ジャーナリストに必要なものは何なのか考えさせられる記事があった。

そもそもジャーナリストという職業が何を意味するのかよく分かっていない。是非ジャーナリストの方と話てみたいと思うが、ここではとりあえずWikipediaのエントリーを見てみる。

A journalist collects and disseminates information about current events, people, trends, and issues.

最近の事柄に関して情報を集めて広める人をジャーナリストというらしい。この定義によれば以下のような能力がジャーナリストには必要であるように思われる:

- 需要のある情報を見極める

- 必要な情報を収集する

- 収集した情報を流通に適した形に加工する

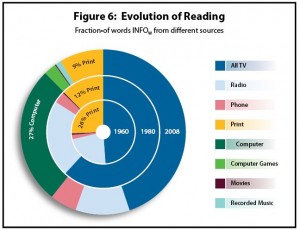

こう考えるとITがジャーナリズムを変えるのは当然だろう。単に流通コストが下がったことで情報を売るのが難しくなったというだけでなく、ジャーナリストの仕事の全ての段階においてITが大きな影響を与えるはずだ。

需要のある情報を見極める能力や集めた情報をうまく流通させる能力はウェブ以前と以後では比べ物にならない。Googleのようにユーザーの行動を把握したり、Facebookのようにソーシャルネットワークを利用して興味を探ったりできる。個人レベルであっても、各種のソーシャルメディアを効果的に利用することでまわりの人、特に自分の観客が何を求めているのかを効果的に把握できる。今まで出来なかったことが出来るようになったゆえに必要となった能力だろう。

必要な情報の収集方法も変わった。調査報道だと例えば政府や企業の不正を暴くという機能がある。以前なら記者クラブに行くとか熱心に取材・聞き込みをすればよかったかもしれない。しかしこれからはそれでは足りない。

Will Columbia-Trained, Code-Savvy Journalists Bridge the Media/Tech Divide?

But even fluency in broadly defined “multimedia skills” isn’t enough, with coding becoming as crucial to the news business as knowing how to use a computer was a couple of generations ago.<

例えば、このWiredの記事はコロンビア大学がジャーナリズムとコンピューターサイエンスのジョイントプログラムを提供していることに際し、ジャーナリストは単にマルチメディアに強いだけではなく、プログラミングのスキルも必要だと指摘している。

これは政府が情報をデジタルデータとして公開する潮流を考えれば当然の流れだろう。情報がない時代にはそれをひたすら探すのが重要だが、逆に情報が溢れている時代には必要な情報をそこから探り当てることのほうが重要だ。そして莫大な情報をさばくにはコードを書くしかない。これには統計情報を、例えばRなどで、処理することも含まれる。

情報が少ないのか多いのか、それが情報を集めて広める職業に大きな影響を与えるのはごく自然なことだ。

さらに今回の記事では、そのコーディング能力すら十分とは言えないという。

That’s all well and good, but having all those programmer journalists looking for access to public data brings to the forefront questions about who owns public records and who has the right to put limits on their use.

何故なら、政府が情報公開の流れに逆らおうとするためだ。情報処理能力があっても情報がなければ意味のある情報を得ることはできない。再び情報の少なさが問題となっているわけだ。

しかし、同じ情報の少なさでも対策は以前とは異なる。今回、情報が少ないのは政府が情報公開の規則を何らかの方法でねじ曲げてそれを拒んでいるためだ。

While Section 105 of the Copyright Act makes works of the federal government ineligible for copyright protection, this provision does not apply to state and local governments.

アメリカの様子が描かれている。著作権法は連邦政府の文章に保護を与えていないが、地方政府には適用されない。

In New York, for instance, state and local agencies may comply with their obligations under the state Freedom of Information Law while maintaining their copyright, and the public records law “does not prohibit a state agency from placing restrictions on how a record, if it were copyrighted, could be subsequently distributed.”

そこを利用して州政府が情報公開を拒むための法律を作っている。

Of course, even when a government entity claims copyright over public data, that protection is at best thin. In general, datasets are protectable as compilations, meaning only the original selection, coordination, or arrangement of facts is protected.

しかし、行政の情報というのはデータベースに該当することが多く、少なくともアメリカでは、実施的な保護はない。

In the case where a third party provides the government with information under a contract, the government agency may not be free to let you do anything you want with it.

そうすると行政は情報=データベースの作成を第三者に依頼する。それによって作成された情報の製作者が行政機関ではなくなるからだ。

記事中で明示されてはいないが、ここで必要な能力はリーガルなものだろう。行政が処理すべき情報の公開を法律・契約を使って阻んでいる以上、それを突破するには情報を収集する側の知識がかかせない。

ITによってジャーナリズムが出来ることの範囲は大きく広がり、その結果としてジャーナリストに必要な能力も増えた。これ自体はよいことだが、ITは同時に紙媒体の収益性を奪い、単なる情報から利益を上げるのを難しくした。プログラムが書けて法律も分かるジャーナリストをこの業界がサポートできるかという話だ。

ITと情報公開の流れが可能にした、莫大な情報をコードを駆使して処理し得られた情報を低(限界)費用で配布するというモデルがビジネスとして成り立つのだろうか。